不知道你是否也在企业中使用过 Confluence,或者其他类似的 Wiki 工具。刚接触它时,我觉得这玩意儿真不错:功能强大、支持各种排版样式、可以插入图片、视频、图标,还能查看历史版本,使用体验比 Git 轻松太多了。

但慢慢地,我发现了它的一个巨大问题:每个人都可以创建并维护自己的 Wiki 页面。

一开始,这种自由看起来是优势。但时间一长,问题就来了:同一个主题的内容,可能会被不同的人写了多个版本。尤其是在项目或产品从一个团队交接到另一个团队时(在外企这是很常见的操作),新团队成员可能不会在原有文档上继续维护,而是习惯另起炉灶,记录自己的理解。

于是,旧的 Wiki 随着人员流动逐渐失效(原作者可能早已离职),新的 Wiki 内容又不够完善甚至有误。这样一来,知识沉淀不仅没有统一,反而更混乱了。

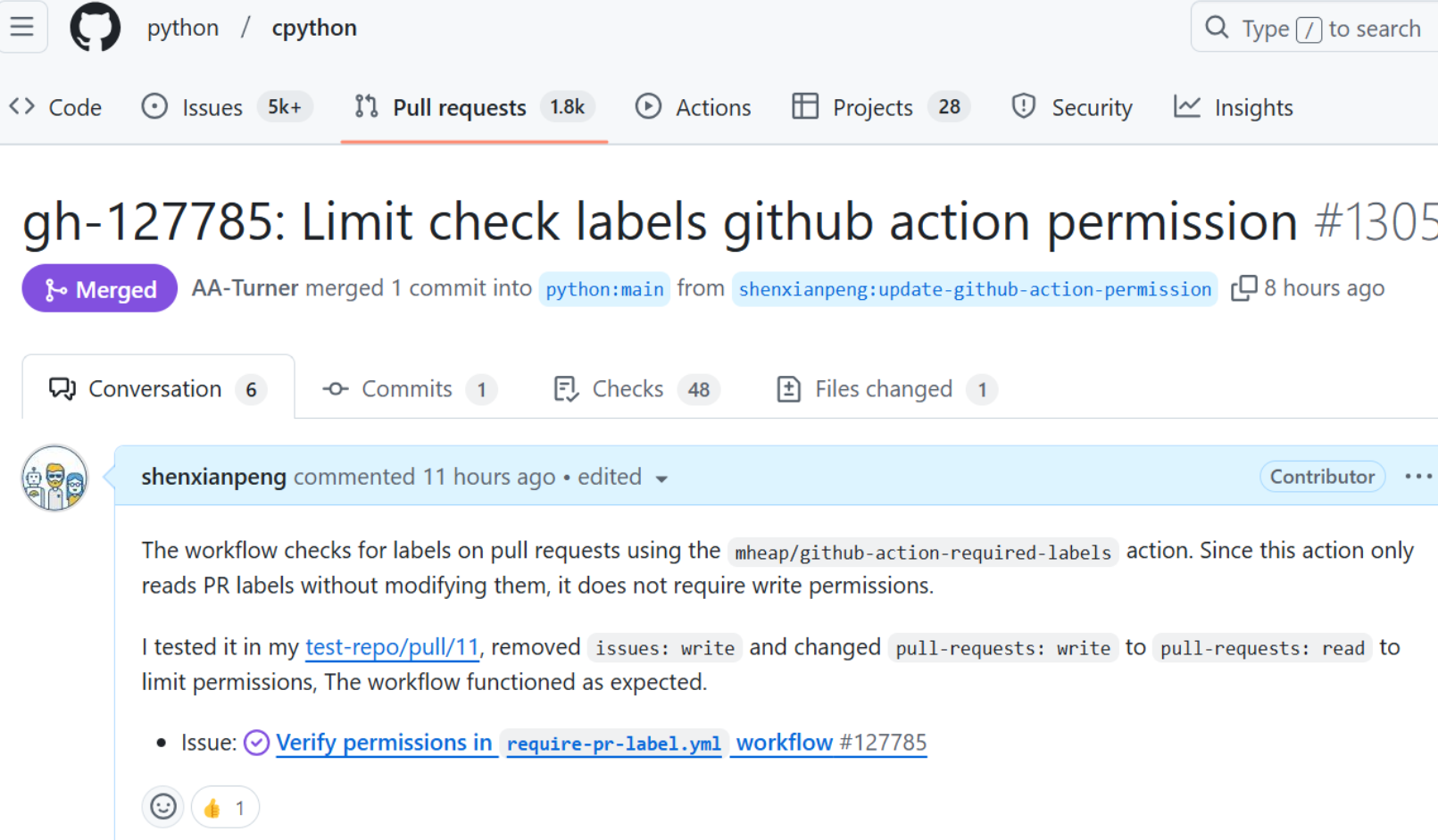

我始终认为 Wiki 工具本身是好的,但如果缺乏统一的管理机制、没有像 Git 那样的 Pull Request 审批流程,那最终它就容易沦为垃圾信息的生产场。

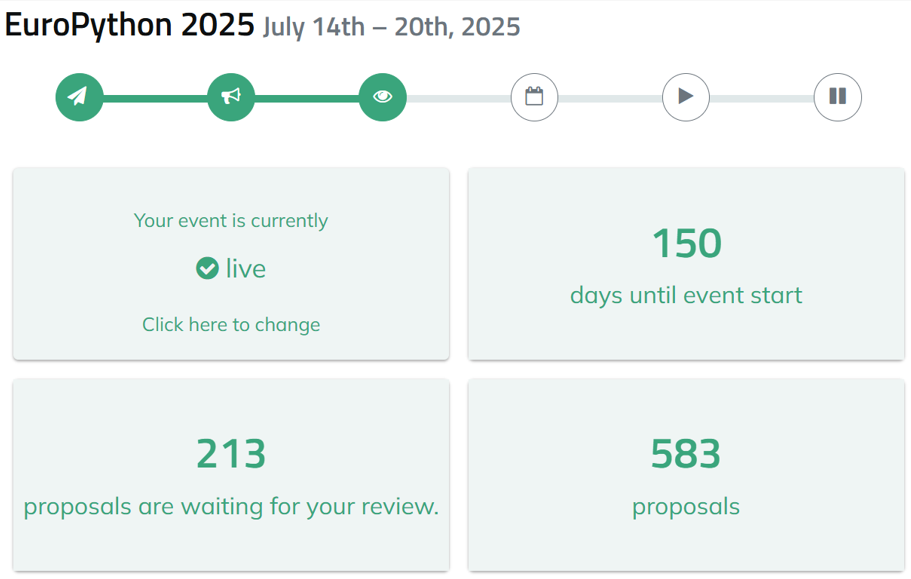

相比之下,开源社区在这方面反而做得很好。